Redis面试题

什么是 Redis?

Redis 是一种基于内存的数据库,对数据的读写操作都是在内存中完成,因此读写速度非常快,常用于缓存,消息队列、分布式锁等场景

Redis是单线程的,但是为什么还那么快?

1、完全基于内存的,C语言编写

2、采用单线程,避免不必要的上下文切换(关闭文件、AOF 刷盘、释放内存是会启动后台线程(BIO)的)

3、使用多路I/O复用模型,非阻塞IO

例如:RDB和AOF都是在后台执行操作,不影响主线程的正常使用,不会产生阻塞

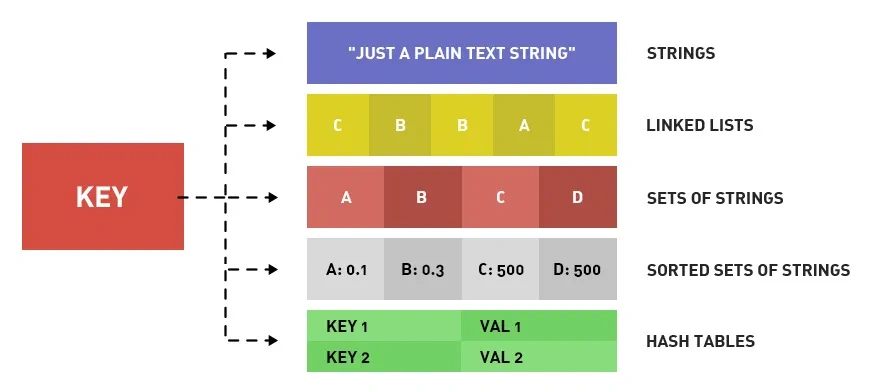

Redis 数据类型以及使用场景分别是什么?

- 5 种基础数据类型:String(字符串)、List(列表)、Set(无序唯一集合)、Zset(有序唯一集合)、Hash(散列)。

- 3 种特殊数据类型:HyperLogLog(基数统计)、Bitmap(位图)、Geospatial(地理位置)。

除了上面提到的之外,还有一些其他的比如 Bloom filter(布隆过滤器)、Bitfield(位域)。

- String 类型的应用场景:缓存对象、常规计数、分布式锁、共享 session 信息等。

- List 类型的应用场景:消息队列(但是有两个问题:1.生产者需要自行实现全局唯一 ID;2.不能以消费组形式消费数据)等。

- Set 类型的应用场景:聚合计算(并集、交集、差集)场景,比如点赞、共同关注、抽奖活动等。

- Zset 类型的应用场景:排序场景,比如排行榜、电话和姓名排序等。

- Hash 类型的应用场景:缓存对象、购物车等。

参考:

什么是缓存穿透?怎么解决?

缓存穿透是指查询一个一定不存在的数据,如果从存储层查不到数据则不写入缓存,这将导致这个不存在的数据每次请求都要到DB去查询,可能导致DB挂掉。这种情况大概率是遭到了攻击。

解决方案的话,我们通常都会用布隆过滤器来解决它

你能介绍一下布隆过滤器吗?

布隆过滤器主要是用于检索一个元素是否在一个集合中。我们当时使用的是redisson实现的布隆过滤器。

它的底层主要是先去初始化一个比较大数组,里面存放的二进制0或1。在一开始都是0,当一个key来了之后经过3次hash计算,模于数组长度找到数据的下标然后把数组中原来的0改为1,这样的话,三个数组的位置就能标明一个key的存在。查找的过程也是一样的。

当然是有缺点的,布隆过滤器有可能会产生一定的误判,我们一般可以设置这个误判率,大概不会超过5%,其实这个误判是必然存在的,要不就得增加数组的长度,其实已经算是很划分了,5%以内的误判率一般的项目也能接受,不至于高并发下压倒数据库。

什么是缓存击穿?怎么解决?

缓存击穿的意思是对于设置了过期时间的热点key,缓存在某个时间点过期的时候,恰好这时间点对这个Key有大量的并发请求过来,这些请求发现缓存过期一般都会从后端DB加载数据并回设到缓存,这个时候大并发的请求可能会瞬间把DB压垮。

解决方案有两种方式:

第一可以使用分布式锁:当缓存失效时,不立即去查询数据库,先使用如Redis的setnx去设置一个互斥锁,当操作成功返回时再进行查询数据库的操作并回设缓存,否则重试get缓存的方法

第二种方案可以设置当前key逻辑过期,大概是思路如下:

①:在设置key的时候,设置一个过期时间字段一块存入缓存中,不给当前key设置过期时间

②:当查询的时候,从redis取出数据后判断时间是否过期

③:如果过期则开通另外一个线程进行数据同步,当前线程正常返回数据,这个数据不是最新当然两种方案各有利弊:

如果选择数据的强一致性,建议使用分布式锁的方案,性能上可能没那么高,锁需要等,也有可能产生死锁的问题

如果选择key的逻辑删除,则优先考虑的高可用性,性能比较高,但是数据同步这块做不到强一致。

什么是缓存雪崩?怎么解决?

缓存雪崩意思是设置缓存时采用了相同的过期时间,导致大量缓存在某一时刻同时失效,请求全部转发到DB,DB瞬时压力过重雪崩。与缓存击穿的区别:雪崩是很多 key,击穿是某一个 key缓存。

解决方案主要是可以将缓存失效时间分散开,比如可以在原有的失效时间基础上增加一个随机值,比如1-5分钟随机,这样每一个缓存的过期时间的重复率就会降低,就很难引发集体失效的事件。

缓存三兄弟

穿透无中生有key,布隆过滤null隔离。

缓存击穿过期key,锁与非期解难题。

雪崩大量过期key,过期时间要随机。

面试必考三兄弟,可用限流来保底。

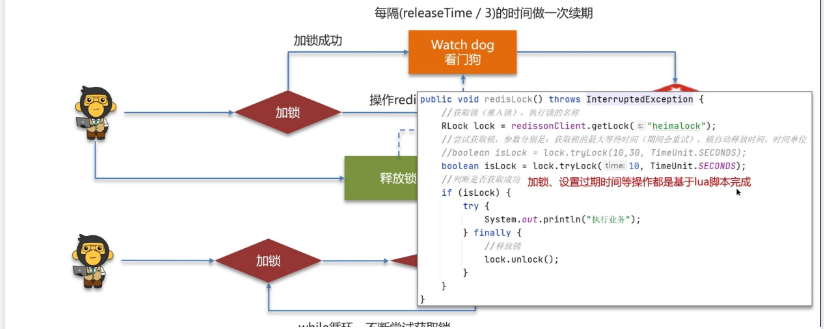

Redis分布式锁如何实现?

我们当使用的redisson实现的分布式锁,底层是setnx和lua脚本(保证原子性)

由于redis的单线程的,用了命令之后,只能有一个客户端对某一个key设置值,在没有过期或删除key的时候是其他客户端是不能设置这个key的

那你如何控制Redis实现分布式锁有效时长呢?

在redisson中需要手动加锁,并且可以控制锁的失效时间和等待时间,当锁住的一个业务还没有执行完成的时候,在redisson中引入了一个看门狗机制(WatchDog),一个线程获取锁成功以后没有设置锁自动释放时间的话,WatchDog会给持有锁的线程续期(默认是每隔10秒续期一次),就是说每隔一段时间就检查当前业务是否还持有锁,如果持有就增加加锁的持有时间,当业务执行完成之后需要使用释放锁就可以了

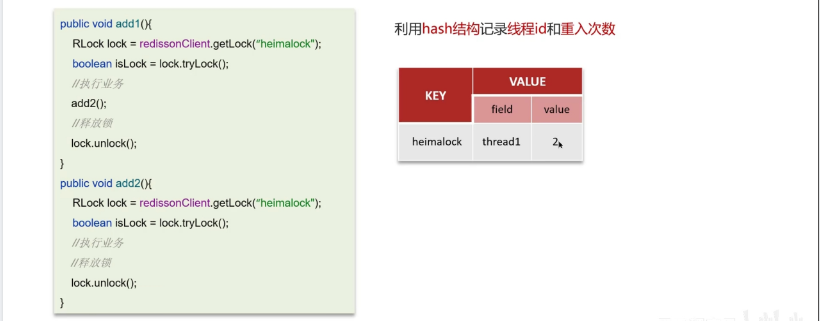

redisson实现的分布式锁是可重入的吗?

嗯,是可以重入的。这样做是为了避免死锁的产生,在存储数据的时候采用的hash结构,来存储线程信息和重入的次数,大key可以按照自己的业务进行定制,其中小key是当前线程的唯一标识,value是当前线程重入的次数。这个重入其实在内部就是判断是否是当前线程持有的锁,如果是当前线程持有的锁就会计数,如果释放锁就会在计算上减一。

Redisson锁能解决主从数据一致的问题吗

不能解决,但是可以使用redisson提供的红锁来解决,但是这样的话,性能就太低了,如果业务中非要保证数据的强一致性,建议采用zookeeper实现的分布式锁

redis做为缓存,mysql的数据如何与redis进行同步呢?(双写一致性)

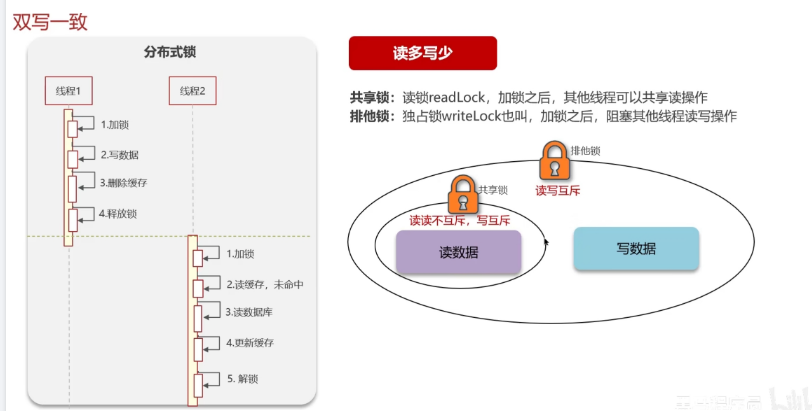

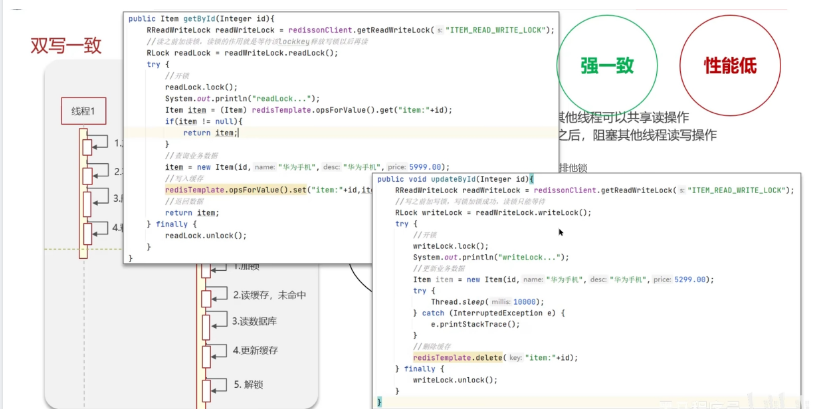

1.强一致性的,采用Redisson提供的读写锁

①共享锁:读锁readLock,加锁之后,其他线程可以共享读操作

②排他锁:独占锁writeLock也叫,加锁之后,阻塞其他线程读写操作

嗯!就说我最近做的这个项目,里面有 xxxx(根据自己的简历上写)的功能,需要让数据库与redis高度保持一致,因为要求时效性比较高,我们采用的是redisson实现的读写锁保证的强一致性。在读的时候添加共享锁,可以保证读读不互斥;当我们更新数据的时候,添加排他锁,它是读写,读读都互斥,这样就能保证在写数据的同时是不会让其他线程读数据的,避免了脏数据。这里面需要注意的是读方法和写方法上需要使用同一把锁才行。其实排他锁底层使用也是setnx,保证了同时只能有一个线程操作锁住的方法

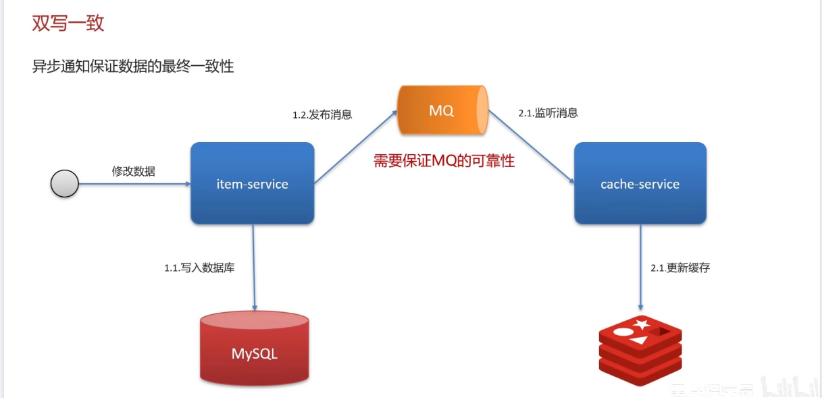

2.允许延时一致的业务,采用异步通知

①使用MQ中间中间件,更新数据之后,通知缓存删除

②利用canal中间件,不需要修改业务代码,伪装为mysql的一个从节点,canal通过读取binlog数据更新缓存

介绍自己简历上的业务,我们当时是把文章的热点数据存入到了缓存中,虽然是热点数据,但是实时要求性并没有那么高,所以,我们当时采用的是异步的方案同步的数据

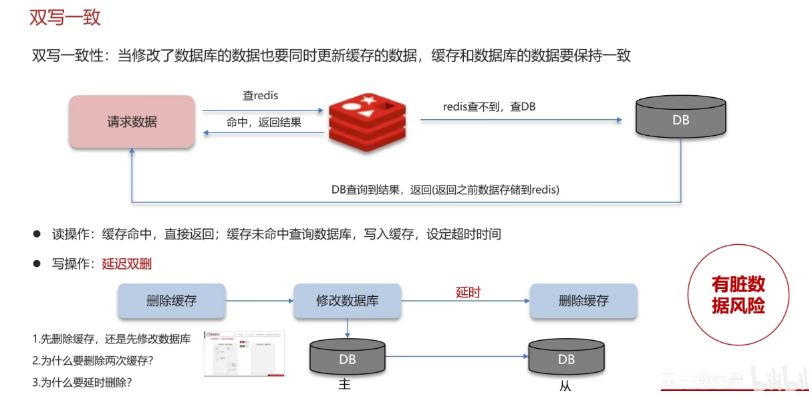

双写一致性-延迟双删

你听说过延时双删吗?为什么不用它呢?

延迟双删,如果是写操作,我们先把缓存中的数据删除,然后更新数据库,最后再延时删除缓存中的数据,其中这个延时多久不太好确定,在延时的过程中可能会出现脏数据,并不能保证强一致性,所以没有采用它。

双写一致性-分布式锁读写锁

双写一致性-异步通知

Redis 的大 key 如何处理?

大 key 并不是指 key 的值很大,而是 key 对应的 value 很大。 一般而言,下面这两种情况被称为大 key:

-String 类型的值大于 10 KB;

-Hash、List、Set、ZSet 类型的元素的个数超过 5000个;

如何找到大 key ?

1、redis-cli --bigkeys 查找大key

redis-cli -h 127.0.0.1 -p6379 -a "password" -- bigkeys2、使用 SCAN 命令查找大 key

3、使用 RdbTools 工具查找大 key

# 将大于 10 kb 的 key 输出到一个表格文件

rdb dump.rdb -c memory --bytes 10240 -f redis.csv如何删除大 key?

1、分批次删除 2、异步删除

redis的持久化是怎么做的?

在Redis中提供了两种数据持久化的方式:1、RDB 2、AOF,一般两种混合使用

(1) RDB是一个快照文件,简单来说就是把内存中的所有数据都记录到磁盘中。当Redis实例故障重启后,从磁盘读取快照文件,恢复数据

[root@localhost ~]# redis-cl i

127.0.0.1:6379> save #由Redis主进程来执行RDB,会阻塞所有命令

ok

127.0.0.1:6379> bgsave #开启子进程执行RDB,避免主进程受到影响

Background saving startedRedis内部有触发RDB的机制,可以在redis.conf文件中找到,格式如下:

#900秒内,如果至少有1个key被修改,则执行bgsave

save 9001

save 30010

save 6010000(2) AOF的含义是追加文件,当redis操作写命令的时候,都会存储这个文件中,当redis实例宕机恢复数据的时候,会从这个文件中再次执行一遍命令来恢复数据。默认是关闭的,需要修改redis. conf配置文件来开启AOF:

#是否开启AOF功能,默认是no

appendonly yes

#AOF文件的名称

appendfilename" appendonly. aof"AOF的命令记录的频率也可以通过redis. conf文件来配:

#表示每执行一次写命令,立即记录到AOF文件(同步刷盘 可靠性高,几乎不丢数据 性能影响大)

appendfsync always

#写命令执行完先放入AOF缓冲区,然后表示每隔1秒将缓冲区数据写到AOF文件,是默认方案(每秒刷盘 性能适中 最多丢失1秒数据)

appendfsync everysec

#写命令执行完先放入AOF缓冲区,由操作系统决定何时将缓冲区内容写回磁盘(操作系统控制 性能最好 可靠性较差,可能丢失大量数据)

appendfsync noRDB和AOF这两种方式,哪种恢复的比较快呢?

RDB因为是二进制文件,在保存的时候体积也是比较小的,它恢复的比较快,但是它有可能会丢数据,我们通常在项目中也会使用AOF来恢复数据,虽然AOF恢复的速度慢一些,但是它丢数据的风险要小很多,在AOF文件中可以设置刷盘策略,我们当时设置的就是每秒批量写入一次命令

Redis的数据淘汰策略有哪些?

嗯,这个在redis中提供了很多种,默认是noeviction,不删除任何数据,内部不足直接报错

是可以在redis的配置文件中进行设置的,里面有两个非常重要的概念,一个是LRU,另外一个是LFU

LRU的意思就是最少最近使用,用当前时间减去最后一次访问时间,这个值越大则淘汰优先级越高。

LFU的意思是最少频率使用。会统计每个key的访问频率,值越小淘汰优先级越高

我们在项目设置的是allkeys-lru,挑选最近最少使用的数据淘汰,把一些经常访问的key留在redis中

数据库有1000万数据,Redis只能缓存20w数据,如何保证Redis中的数据都是热点数据?

可以使用allkeys-lru(挑选最近最少使用的数据淘汰)淘汰策略,那留下来的都是经常访问的热点数据

Redis的数据过期策略有哪些?

在redis中提供了两种数据过期删除策略

第一种是惰性删除,在设置该key过期时间后,我们不去管它,当需要该key时,我们在检查其是否过期,如果过期,我们就删掉它,反之返回该key。

第二种是定期删除,就是说每隔一段时间,我们就对一些key进行检查,删除里面过期的key

定期清理的两种模式:

·SLOW模式是定时任务,执行频率默认为10hz,每次不超过25ms,以通过修改配置文件redis.conf的hz选项来调整这个次数

·FAST模式执行频率不固定,每次事件循环会尝试执行,但两次间隔不低于2ms,每次耗时不超过1ms

Redis的过期删除策略:惰性删除+定期删除两种策略进行配合使用。

Redis集群有哪些方案?

在Redis中提供的集群方案总共有三种:主从复制、哨兵模式、Redis分片集群

那你来介绍一下主从同步

单节点Redis的并发能力是有上限的,要进一步提高Redis的并发能力,可以搭建主从集群,实现读写分离。一般都是一主多从,主节点负责写数据,从节点负责读数据,主节点写入数据之后,需要把数据同步到从节点中

主从同步分为了两个阶段,一个是全量同步,一个是增量同步

全量同步是指从节点第一次与主节点建立连接的时候使用全量同步,流程是这样的:

第一:从节点请求主节点同步数据,其中从节点会携带自己的replication id和offset偏移量。

第二:主节点判断是否是第一次请求,主要判断的依据就是,主节点与从节点是否是同一个replication id,如果不是,就说明是第一次同步,那主节点就会把自己的replication id和offset发送给从节点,让从节点与主节点的信息保持一致。

第三:在同时主节点会执行bgsave,生成rdb文件后,发送给从节点去执行,从节点先把自己的数据清空,然后执行主节点发送过来的rdb文件,这样就保持了一致

当然,如果在rdb生成执行期间,依然有请求到了主节点,而主节点会以命令的方式记录到缓冲区,缓冲区是一个日志文件,最后把这个日志文件发送给从节点,这样就能保证主节点与从节点完全一致了,后期再同步数据的时候,都是依赖于这个日志文件,这个就是全量同步

增量同步指的是,当从节点服务重启之后,数据就不一致了,所以这个时候,从节点会请求主节点同步数据,主节点还是判断不是第一次请求,不是第一次就获取从节点的offset值,然后主节点从命令日志中获取offset值之后的数据,发送给从节点进行数据同步

怎么保证Redis的高并发高可用

首先可以搭建主从集群,再加上使用redis中的哨兵模式,哨兵模式可以实现主从集群的自动故障恢复,里面就包含了对主从服务的监控、自动故障恢复、通知;如果master故障, Sentinel会将一个slave提升为master。当故障实例恢复后也以新的master为主;同时Sentinel也充当Redis客户端的服务发现来源,当集群发生故障转移时,会将最新信息推送给Redis的客户端,所以一般项目都会采用哨兵的模式来保证redis的高并发高可用

你们使用redis是单点还是集群,哪种集群

我们当时使用的是主从(1主1从)加哨兵。一般单节点不超过10G内存,如果Redis内存不足则可以给不同服务分配独立的Redis主从节点。尽量不做分片集群。因为集群维护起来比较麻烦,并且集群之间的心跳检测和数据通信会消耗大量的网络带宽,也没法使用 lua脚本和事务

redis的分片集群有什么作用

分片集群主要解决的是,海量数据存储的问题,集群中有多个master,每个master保存不同数据,并且还可以给每个master设置多个slave节点,就可以继续增大集群的高并发能力。同时每个master之间通过ping监测彼此健康状态,就类似于哨兵模式了。当客户端请求可以访问集群任意节点,最终都会被转发到正确节点